Akustikkoppler

bloggen mit 300 Baud – das Weblog von Andreas Bischoff

Kategorie: Robotik

Screening des Dokumentarfilms Hi, AI im Filmforum Duisburg am 13.6.2019 um 18 Uhr mit anschießenden Expertengespräch mit Isabelle Reiff (SF-Autorin) und Dr.-Ing. Andreas Bischoff (Robotik-Experte Uni Duisburg-Essen/ZIM)

Hi, AI – Liebesgeschichte aus der Zukunft

Filmforum Duisburg

Dellplatz 16

10.00 -19:40 Uhr Vorführung

Der AI-Roboter Pepper

Den Trailer zum Film können Sie hier finden:

19:40 – 20:20 Diskussion und Expertengespräch mit Isabelle Reiff und Dr.-Ing. Andreas Bischoff

Anlässlich des Expertengespräches zur Künstlichen Intelligenz habe ich hier einen kleinen Reader zu den Themen AI (im Deutschen KI) und Robotik zusammengestellt:

Eine sehr schöne umfassende und aktuelle Zusammenstellung zum Thema künstliche Intelligenz finden Sie im ganz wunderbaren Buch „Künstliche Intelligenz“ von Manuela Lentzen.

https://www.chbeck.de/lenzen-kuenstliche-intelligenz/product/22250137

Mein Kollege Dr.-habil. Burkhard Wald hat anlässlich eines Vortrages zum Thema KI eine recht umfassende Linkliste in drei Blogbeiträgen zusammengefasst, die gespickt mit Erklärungslinks in die Wikipedia, sowohl die Geschichte der KI, als auch aktuelle Entwicklungen vorstellt.

Blog 1: http://blogs.uni-due.de/zim/2016/12/11/leseempfehlungen-zur-kuenstlichen-intelligenz-teil-1/

Blog 2: http://blogs.uni-due.de/zim/2016/12/27/leseempfehlungen-zur-kuenstlichen-intelligenz-teil-2/

Blog 3: http://blogs.uni-due.de/zim/2017/01/02/leseempfehlungen-zur-kuenstlichen-intelligenz-teil-3/

Sehr visionäre Ideen zu künstlicher Intelligenz und Bewusstsein finden sich in der Vortragsreiche von Joscha Bach aufgezeichnet auf diversen CCC-Kongressen in englischer Sprache:

https://media.ccc.de/search?q=Joscha

Und in deutscher Sprache in diesem sehr hörenswerten Podcast:

https://wrint.de/2013/03/09/wr156-ortsgesprach-joscha-bach-wg-kunstlicher-intelligenz/

Wer selber programmierren kann oder möchte:

Tensorflow ist ein Softwareframework von Google für Künstliche Neuronale Netze, das in C++ und Python programmiert wird. Wer sich ein bisschen mit Webtechniken und Javascript auskennt, kann auch tensorflow.js ausprobieren:

Ganz ohne eigenes Programmieren lässt sich dieses tensorflow.js Beispiel im Browser ausprobieren:

tensorflow.js-Demo Webcam Controller für PACMAN im Browser.

Viele Infos in englischer Sprache zum Thema Roboter gibt es im The Robot Report.

Kommentare zum Dokumentarfilm:

Da der Film beabsichtigt unkommentiert verschiedene Robotermodelle mit ganz unterschiedlichen Eigenschaften zeigt, möchte ich hier einige technische Einordnungen zu einzelnen Robotern vornehmen:

Der zittrig gehende humanoide (menschenähnliche) Roboter der italienischen Forschergruppe ist möglicherweise wirklich ein mit einer AI (einem neuronalen Netz) selbst lernendes System. In der AI (KI) wird tatsächlich diskutiert, ob für künstliche Intelligenz (künstliches Bewusstsein) ein Körper nötigt ist.

Pepper, der Roboter, der mit die älteren Dame auf Japanisch kommuniziert zeigt einige Eigenschaften, die man in autonomen Robotern künstlich implementiert, damit sich ein für Menschen glaubhaftes Kommunikationsverhalten realisiert werden kann. Menschen mögen es, wenn Sie angesehen werden, wenn man mit Ihren spricht. Das dauernde Anstarren durch einen Roboter wird aber als psychologisch unangenehm empfunden. Wenn der Roboter umher oder zur Decke blickt, wir dieses von Menschen als nachdenken interpretiert.

Der weibliche „Gummipuppen-Roboter“ ist offensichtlich ein Sprach-Dialogsystem, dass in der Cloud läuft, ähnlich Alexa und Siri. Die Antworten und Dialoge des Systems sind recht primitiv und lassen vermuten, da eine Chat-Bot Software eingesetzt wird. Eine sehr bekannte Chat-Bot Software mit den Namen Eliza wurde schon in den 70er Jahren realisiert. Ethiker beschäftigen sich aber tatsächlich damit, Roboter vor einem Einsatz als Sex-Sklaven zu schützen.

Ein kleiner Tipp: Wenn Sie auf Webseiten im Chat oder in Sprachdialogsystemen überprüfen wollen, ob Sie es wirklich mit einem Menschen zu tun haben, machen Sie einen kleinen Turing-Test (ein Test der das Gegenüber auf Intelligenz testet) und fragen Sie den Chat-Partner was er sieht, wenn er aus seinem Bürofenster schaut.

Starke KI – schwache KI – wie weit die Forschung wirklich ist

Mit schwacher KI bezeichnet man Systeme die konkrete Aufgaben lösen wie z.B. künstliche Sprachausgabe, Spracherkennung, Bilderkennung usw. Diese Probleme können mit dem heutigen Stand der Technik als gelöst bzw. beherrschbar angesehen werden. Mit starker KI bezeichnet man echte Künstliche Intelligenz bzw. künstliches Bewusstsein. Eine Definition von KI besagt, dass wenn ein Mensch einen künstlichen Kommunikationspartner nicht von einem echten unterscheiden kann, ist dieser als intelligent zu bezeichnen (Turing-Test).

Alle gezeigten AI-Systeme sind sehr weit von echtem künstlichem Bewusstsein entfernt. Unabhängig vom derzeitigen KI-Hype und Darstellungen in der Science Fiction, ist die Forschung derzeit noch sehr weit von einem künstlichen Bewusstsein entfernt, was unter anderem daran liegt, dass niemand weiß, wie unser Bewusstsein genau funktioniert. Allerdings zeigen die teils bedrückenden Dialoge, was echte oder auch nur vorgegebene AI mit uns Menschen anstellen. Wollen wir im Alter wirklich von Pflegerobotern unterhalten werden? Sollen Dialoge mit Sexspielzeugen in irgendwelchen Clouds abgespeichert werden? Wie verhalten sich Menschen gegenüber intelligenten Maschinen?

Interessanter ist auch die Frage, welche Auswirkungen trainierte künstliche neuronale Netze auf unser Alltagsleben haben werden (oder schon haben). Diese entscheiden schon heute, basierend auf Datenspuren die wir hinterlassen (Big Data), welche Werbung wir angezeigt bekommen, welche Versicherungen uns verweigert werden, welche Therapie bei einer Erkrankung für uns die richtige ist oder nehmen gar Social Scoring (wie in China) vor. Ein Problem künstlicher neuronaler Netze ist immer die Auswahl der Trainingsdaten. Wenn diese Trainingsdaten schon Vorurteile und gefärbte Einschätzungen enthalten, werden die Netze in dieser schon „befangenen“ Weise trainiert. Ein weiteres Problem ist, dass es unmöglich ist, die einzelne Entscheidung eines künstlichen Neuronalen Netzes genau zu verifizieren, also den Grund für eine Entscheidung herauszufinden.

Isabell Reiff und Andreas Bischoff

Isabelle Reiff:

Isabelle Reiff, geboren 1968 in Bremen, arbeitet als freie Journalistin für Fachverlage und Unternehmen. 1994 noch geduldig aufs Freizeichen ihres 14.4k-Modems wartend, ist ihr heute oft nach Digital Detox. Dem Redaktionsvolontariat folgten zwei Informatik-Forschungsprojekte, seitdem gilt ihr Augenmerk den sozialen Implikationen von IT. Das Kulturhauptstadtjahr brachte sie 2010 nach Dortmund, wo sie als Autorin im »2-3 Straßen«-Konzeptkunstwerk von Jochen Gerz die Bewohner der Nordstadt um »Satz-Spenden« bat. In Köln erschienen ihre ersten Kurzgeschichten wie die über einen Mann, den Spam bis in seine Träume

verfolgt. In ihrem 2017 erschienenen Near-Future-Krimi »UhrZeit« sollen alle Dortmunder per Smartwatch optimiert werden.

https://www.text-der-trifft.de/

https://www.reiff-fuer-die-insel.de

Der Near-Future-Krimi »UhrZeit«:

https://www.amazon.de/UhrZeit-ein-Near-Future-Krimi-Isabelle-Reiff-ebook/dp/B074B9TV6W

Andreas Bischoff:

Dr.-Ing. Andreas Bischoff ist seit 19 Jahren wissenschaftlich in Bereichen Robotik, virtueller und augmentierter Realität unterwegs. Seit 9 Jahren beschäftigt er sich an der Universität Duisburg-Essen mit Hochschul-IT. Ab 2011 Ausstellungen mit interaktiven audio-visuellen Videokunstprojekten. Schwerpunkt ist die kritische künstlerische Auseinandersetzung mit dem Leben im Zeitalter von Big Data und globaler Überwachung.

Kunst: https://mediaart.robotnet.de/

Blog: https://www.robotnet.de/

HP: https://www.dr-bischoff.de/

Uni DUE: https://www.uni-due.de/~bischoff/

Sprich Freund und tritt ein – Sprachausgabe für den Raspberry Pi mit eSpeak und SVOX-pico

Embedded Computer sind je nach Einsatzgebiet häufig nicht mit Bildschirmen oder Displays ausgestattet. Wenn sie aber in wechselnden Umgebungen mit oder ohne DHCP eingesetzt werden, ergibt sich häufig die Anforderung einmal schnell die bezogene oder eingestellte IP-Adresse herauszufinden. Natürlich lässt sich dieses Problem komfortabel mit DynDNS lösen, wenn der Rechner auch wirklich mit dem Internet verbunden ist. Ansonsten bleibt immer nur die Suche nach einem neuen Netzwerkgerät im Webinterface des Routers.

Diese Anforderung hatte ich selber ursprünglich für einen mobilen Roboter, der sich in wechselnden Umgebungen bzw. WLAN-Netzen bewegen konnte und per Webinterface bedient wurde. Um den Roboter initial zu finden, musste die IP-Adresse bekannt sein.

Aber auch für Zwecke der Heimautomatisierung eingesetzte Mini-Rechner müssen nicht immer mit Display betrieben werden. Für die Ausgabe seltener Störungen bietet sich das Audio-Interface, also die Soundkarte, als preiswerte und stromsparende Alternative an.

Mein mobiler Activemedia Pioneer 3AT Roboter mit Sprachausgabe 2006 FernUni in Hagen, damals realisiert mit MBROLA

Computergenerierte künstliche Sprachausgabe wird mit sogenannter Text-to-Speech-Software TTS realisiert. Diese Software setzt mit Hilfe von umfangreichen Aussprache-Lexika oder Heuristiken (Regeln) für die Zielsprache geschriebenen Text zunächst in eine Abfolge einzelner Laute (Phoneme) um. Die einzelnen Laute, bzw. deren Kombinationen werden entweder von einem Menschen bei der Erstellung der Software eingesprochen oder ebenfalls synthetisch (Signalsynthese oder Formantsynthese) erzeugt. Neuere Systeme basieren auf einem umfangreiche Wortschatz an von einem Menschen gesprochenen Worten, so das eine nahezu natürliche Sprache generiert werden kann. Selbst die Herausforderung eine natürliche Sprachmelodie (Prosodie) zu erzeugen, scheinen moderne kommerzielle Systeme zu meistern. Nun erfordert so eine hochqualitative Sprachdatenbank sehr viel Speicherplatz und ist aufwändig und teuer zu produzieren. Trotz allem gibt es im Open-Source-Bereich brauchbare und auch schlanke freie TTS-Programme. Eine sehr Ressourcen-sparende TTS-Software ist eSpeak. Diese Software wurde ursprünglich auf einem Acorn RISC_OS Computer, also auch auf einer ARM-Architektur, entwickelt und eignet sich durch Ihre Kompaktheit, Ausführungsgeschwindigkeit und geringen Speicherbedarf besonders für Embedded Systeme. Außerdem unterstützt espeak über 20 Sprachen. An die Aussprache muss man sich etwas gewöhnen, sie ist aber verständlich.

Die auf dem Raspberry-Pi verwendete Debian-Variante Rasbian unterstützt eSpeak out-of-the-box.

Mit

sudo apt-get install espeak

ist die Installation erledigt. Die Ausgabe testen kann man testen, nachdem man das Audiointerface auf den Klinkenstecker per Alsamixer umgestellt hat. Default ist beim Rasberry PI Audioausgabe über HDMI. In /etc/config.txt kann das aber auch fest eingestellt werden.

sudo amixer cset numid=3 1

espeak -vde “hallo welt hier spricht der räspberri pei”

Wenn keine Option -w angegeben wird, gelangt die Ausgabe direkt an das Audio-Device /dev/dsp .

Höhere Sprachqualität mit SVOX-Pico

Eine Alternative mit der derzeit besten Sprachqualität im Open-Source-Bereich stellt die SVOX-Pico-TTS-Engine dar. Vielleicht kommt dem einen oder anderen Nutzer die Stimme bekannt vor. SVOX-Pico ist die in den Android-Versionen 2.1-2.3 eingesetzte Default-Sprachausgabe. Die neue, ab der Version 4.0 von Google für Android eingesetzte TTS-Engine, basiert leider auf Closed-Source-Software. Die SVOX-Pico TTS-Engine ist übrigens auch die Default-Engine für meine Wikipedia-Sprachausgabe Pediaphon und unterstützt neben Englisch (UK und US), Deutsch, Französisch auch Italienisch und Spanisch in hoher Qualität.

SVOX-Pico liegt als Open-Source vor, ist auf diverse Linux-Varianten portiert worden und lässt sich z.B. unter Ubuntu einfach mit sudo apt-get install pico2wave installieren. Für Raspbian muss das Paket selber kompiliert werden. Alternativ können Sie mein Debian-Paket für Rasbian ARM einfach herunterladen (MD5-Hash: b530eb9ff97b9cf079f622efe46ce513) und mit den Kommandos

apt-get install libpopt-dev

sudo dpkg --install pico2wave.deb

auf dem Rasberry Pi installieren. Das libpopt-dev ist ebenfalls erforderlich.

Mit

sudo amixer cset numid=3 1

pico2wave --lang=de-DE --wave=/tmp/test.wav "hallo welt hier spricht der räspberri pei"; play /tmp/test.wav;rm /tmp/test.wav

können Sie die Sprachausgabe testen.

Mit

sudo apt-get remove pico2wave

kann man das Debian-Paket auch wieder sauber deinstallieren.

Wer selber kompilieren möchte, muss neben know how etwas Geduld mitbringen.

Um die Quellen zu kompilieren ist neben automake auch das libtool erforderlich:

git clone -b upstream+patches git://git.debian.org/collab-maint/svox.git svox-pico

apt-get install automake libtool libpopt-dev

automake

./autogen.sh

./configure

make all

make install

Alternativ kann man auch ein direkt ein Debian-Paket bauen, dass auch sauber wieder aus dem System entfernt werden kann.

Ich habe zusätzlich für mein Binary die GCC-Optionen

-mcpu=arm1176jzf-s -mfpu=vfp -mfloat-abi=hard

passend für den Raspberry Pi angepasst, damit auch die Hardware floation-point Unterstützung genutzt wird.

Um dann z.B. beim Bootvorgang automatisch die IP-Adresse des Pis zu sprechen, habe ich in der /etc/rc.local folgende Kommandos eingefügt:

/usr/bin/amixer cset numid=3 1

/usr/bin/espeak -vde "meine ei pie Adresse lautet $_IP"

Sicherlich lassen sich noch eine Menge anderer sinnvolle Anwendungen für eine Sprachausgabe auf dem PI finden. Mit seinen Sensoren kann der Pi auch als ein preiswertes Hilfsmittel für Blinde-Nutzer eingesetzt werden.

CeBIT 2014 Tipps – ein Merkelphone macht noch keinen Sommer – IT im Schatten der NSA-Affäre

Als Überzeugungstäter war ich auch im Jahr 2014 wieder auf der CeBIT, obwohl ich jedes Mal denke die Messe hat sich überholt. Man muss nicht wirklich dort gewesen sein. Aber die unaufgeregte fast provinzielle Atmosphäre dort gefällt mir wesentlich besser als die unglaublich hippe Dot-Com-Zeit im Hannover der Jahrtausendwende.

Obwohl Datenschutz auch auf den letzten beiden CeBIT-Messen ein Schwerpunktthema war, war ich doch gespannt, wie sich die NSA-Affäre auf die IP-Welt dort so auswirkt. Business as usual mit Daten weltweit verteilt in der Cloud, oder auch kritische Töne auf der IT-Messe? Die NSA-Affäre beginnt vielleicht nun einigen Anbietern wirklich Geld zu kosten und die Kunden sind für das Thema Datensicherheit sensibilisiert worden. Auf der CeBIT war dazu aber bis auf Lippenbekenntnissen recht wenig zu hören. Das Thema Cloud wurde weiter ge-hyped als ob nichts geschehen wäre. Allerdings gab es wieder viel Interesse an Live-Hacking-Events mit mobilen Endgeräten. Zumindest die Nutzer scheinen also sensibilisiert zu sein. Die Firma SecuSmart positioniert das Merkelphone nun auch für Firmen- und Privatanwender, aber das nützt nicht wirklich etwas, solange die Bundesregierung in der NSA-Affäre völlig untätig bleibt.

Ärgerlich war wieder einmal die CeBIT-App. Die Messe-AG greift in diesem Bereich immer wieder sicher ins Klo. Nicht nur das wirklich krude Bedienkonzept für eine App, die man ja nur kurz bei einem Messebesuch bedienen soll, sondern auch technische Dinge wie der Akku- und Datenverbrauch sind eine Katastrophe. Aussteller in der Suche zu finden ist Glückssache und ein Klick auf die Standnummer holt nicht etwa den Messeplan nach vorn, es passiert einfach gar nichts. Besonders glücklich ist der Messebesucher, wenn er für eine frisch installierte App sofort Datenupdates ziehen muss. Ich kann nur jedem Benutzer raten, sich einfach die PDF-Pläne herunterzuladen. Vielleicht kommt die Messe-AG ja einmal auf die Idee die Ausstellerdaten einfach als Datenbankexport öffentlich zu machen. Dann gibt es bestimmt sofort sehr viel bessere open source Lösungen.

Die CeBit App stürzt gerne mal ab und frisst Daten

Wirklich innovative Dinge bekommt man auf der CeBIT leider nur noch im Hochschulbereich zu sehen. Dort war das DFKI mit einem affenartigen Roboter zu sehen und hatte auch interaktives Fernsehen verknüpft mit semantic web im Gepäck. Eine schönen orangenen NAO habe ich mir direkt beim Hersteller Aldebaran angeschaut. Auch weiterhin werden NAOs leider nur an Hochschulen verkauft, Privatleute haben keine Chance. Der Preis liegt auch immer noch wie festgenagelt bei ca. 5000 €.

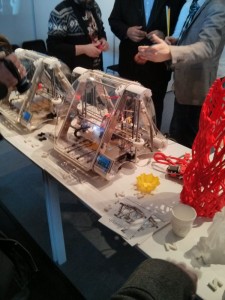

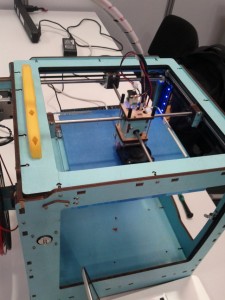

Absolute Publikumsmagneten waren 3D-Drucker von denen es eine ganze Batterie in unterschiedlichen Ausprägungen von unterschiedlichen Herstellern zu sehen gab (MakerBot Mini, Ultimaker, Airwoolf 3D, Zmorph). Pearl setzt dem Trend einmal mehr die Krone auf und bietet ein etwa Lötkolben-großes freihändiges Gerät für Leute mit absoluter Körperbeherrschung an. Eigentlich ist es aber nur eine bessere Heißklebepistole, die aber das gleiche Granulat wie in den 3D-Druckern als Druckmedium verwendet.

Auch Quadcopter-Drohnen scheinen nun im Endkundenmarkt angekommen zu sein. Die Firma DJI (www.dji.com) hatte von der relativ kompakten Phantom 2 Vision bis hin zu dem beeindruckenden, vielleicht sogar angsteinflößenden Modell mit der Bezeichnung „Spreading Wings S1000 Premium“, die eine ganze DSLR tragen kann, eine ganze Palette von Kameradrohnen im Programm. Nicht auszudenken wenn, wie bei Daniel Suarez im Roman kill decision jemand auf die Idee kommt die Nutzlast zu verändern.

Was mir auch noch außerordentlich gut gefallen hat sind die wirklich todschicken Rechner von “i am eco” (www.iameco.com), die eigentlich als nachhaltige Computer gedacht sind. Die edlen wohnzimmertauglichen Holzgehäuse sind aus nachhaltig in Europa hergestellten Hölzern gefertigt. Das wunderschöne D4R-Laptop (Notebook, auch die Bezeichnung scheint nachhaltig zu sein ![]() wird mit Abfallhölzern aus der Möbelproduktion aufgehübscht. Technisch verbinden die Rechner stromsparende, lüfterlose (das Standgerät mit Dual Core Prozessor und 7 Watt) Green-IT mit attraktiven Äußeren. Das „Laptop”-Notebook ist sogar auch mit aktuellem Core i7 Prozessor erhältlich.

wird mit Abfallhölzern aus der Möbelproduktion aufgehübscht. Technisch verbinden die Rechner stromsparende, lüfterlose (das Standgerät mit Dual Core Prozessor und 7 Watt) Green-IT mit attraktiven Äußeren. Das „Laptop”-Notebook ist sogar auch mit aktuellem Core i7 Prozessor erhältlich.

Diese Rechner sollen für 10 Jahre in Benutzung bleiben, was zunächst einmal recht ambitioniert klingt. Da sich ja auch in den letzten fünf Jahren die Taktfrequenzen nicht mehr wesentlich erhöht haben, kann das bei Verwendung geeigneter Betriebssysteme vielleicht sogar funktionieren. Auf jeden Fall sind die Geräte einfach schön und werden Ihren Markt sicher finden.

CeBIT 2013 – 3D-Drucker, Google Glasses Alternativen und BYOD

Obwohl es heutzutage viel einfacher ist sich im Web über innovative Technologien zu informieren und die CeBIT nicht wirklich immer schnell auf neue Trends reagiert, bin ich als Überzeugungstäter wieder dort gewesen.

Viele Aussteller weichen den Kugelschreiber- und Mauspad-Sammlern in den geschlossenen Planet Reseller Bereich aus. Tatsächlich war ich in diesem Jahr das erste Mal in diesem Bereich und war enttäuscht, dass es auch dort nur wenig wirklich interessante Dinge zu sehen gab. Scheinbar geht es bei diesem Bereich wohl nur darum Sex sells Geschmacklosigkeiten der Austeller vor dem Massenpublikum zu verbergen. Auf der nächsten CeBIT werde ich mir diesen Bereich wohl schenken. Pearl präsentierte aber nur dort einen interessanten Fensterputz-Roboter. Service-Robotik ist also massentauglich geworden.

Auch der Bereich Webcity nimmt an Relevanz leider stark ab. Mit Themen wie Social Marketing hat sich der Bereich nun sehr weit von dem ursprünglich innovativen Web 2.0 oder gar netzpolitischen Themen weit entfernt.

Sogar der Hochschulbereich hat mich dieses Jahr bis auf wenige Ausnahmen gelangweilt. Interessant fand ich aber das Echtzeit Facetracking dieses Mal eingesetzt für Videokonferenzen der RWTH-Aachen. Für Robotik-Interessierte gab es auch einen Unterseeroboter zu sehen. Anscheinend gibt es das Gerät nicht nur für zivile Zwecke (SeaOtter_civil.PDF) .

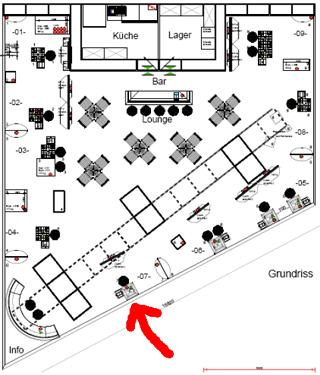

Trotzdem lässt sich die Messe AG auch neue Konzepte einfallen. Hervorzuheben bei den interessanten Neuerungen sind die Developer Area und der kleine Coworking Place in Halle 17. Sehr spannend fand ich den offenen Workshop zu 3D-Druckern. Allerdings vertraut die Messe AG anscheinend dem externen Anbieter Amiando mehr als ihrem eigenem Registrierungssystem ![]() .

.

Niels Hitze von 3ddinge.de stellte in der Developer Area Hard- und Software zum 3D-Drucken aber auch die Maker und Fabber-Bewegung vor. Trotz Probleme mit dem WLAN (kein Wunder auf der CeBIT) gab es die Möglichkeit einem Makerbot (dem Replicator 2) bei der Arbeit über die Schulter zu schauen. Neben Grundlagen zu Hard- und Software und Datenformaten gab es auch Erfahrungen in der Konstruktion von Abstützungen und Tipps zu Materialien, Materialeigenschaften und Finish aus erster Hand. Auch auf aktuelle ethische und politische Problemstellungen, wie beispielsweise die Produktion von Waffen mit 3D-Druckern und der aktuellen Diskussion zu Auswirkungen auf das Urheberrecht und geistiges Eigentum, die eine Welt von Fabbern aufwirft, wurde eingegangen. Auch vielleicht etwas SciFi-mäßig angehauchte Ideen der ESA Mondstaub als Medium für 3D-Drucker zu verwenden wurden erwähnt. Eine Thematik die für mich ganz neu war ist der Einsatz von 3D-Drucken die aus Eiweißen und Proteinen synthetische Lebensmittel oder sogar Fleisch “drucken”. Lecker, da bleiben die Pferde aus der Lasagne draußen.

Neben autostereoskopischen Displays ist auch Augmented Reality für Head Mounted Displays durch den Hype um die Google Glasses wieder ein Thema. Zeiss stellte eine Brille vor die ich vor zwei Jahren schon auf der CeBIT gesehen habe und die schon damals angeblich in einem halben Jahr serienreif sein sollte. Noch spannender war ein Kickstarter Projekt namens GlassUp, dass aber noch keine live Daten darstellen konnte.

Ein interessantes Thema auf der CeBIT war auch “Bring your own device (BYOD)”. Sehr viel Spaß hatte ich bei der Podiumsdiskussion am Donnerstag zu BYOD in Halle 6, Stand C04. Dort ging es im Rahmen des “Mobile Business Solutions Forum” um “BYOD – Fluch oder Segen für die Unternehmens-IT?“. Dort fand ich einige meiner eigenen Ansichten zum Thema BYOD bestätigt. Offensichtlich bin ich, sowohl mit meinen Sicherheitsbedenken, als auch mit der Ansicht, BYOD ist für die Nutzer großartig und faszinierend, nicht alleine.

Cebit 2012 Managing Trust – das Vertrauen verloren?

Der Cebit 2012 fehlten spannende technische Neuheiten und so wurde das Thema Sicherheit zum Motto erhoben.

Ich habe bei meinem Besuch trotzdem einige Perlen auf der CeBit entdeckt und bin dann noch rein zufällig auf das Barkamp „Datenschutz 2.0“ organisiert vom Grünen Europaabgeordneten Jan Philipp Albrecht gestoßen. Ein Barcamp auf der Cebit, fragte ich und wurde eingeladen zu bleiben.

Dort ging es in erster Linie um die neue Datenschutzrichtlinie der EU, die dort diskutiert wurde. Allein der Umfang des Papiers verhinderte eine erschöpfende Beschäftigung mit diesem Thema, allerdings wurden schon bei den ersten Paragraphen die Schwachstellen bzw. der Diskussionsbedarf deutlich.

Dort hatte ich die Gelegenheit den sehr spannenden Vortrag von Martin Rost zum Thema „Philosophische Grundlagen des Datenschutzes“ mitzunehmen und auch an der anschließenden Diskussion teilzunehmen. Das war sehr spannend, fernab von „Verfahrensbeschreibungen“ und IT-Grundschutz, was ich in meiner berufliche Praxis eigentlich mit dem Thema verbinde, betonte Herr Rost das Grundrecht auf informationelle Selbstbestimmung und die Parteilichkeit von Datenschutz. Laut Rost muss Datenschutz immer auf der Seite des schwächeren Kommunikationspartner stehen, bei Arbeitsverhältnissen auf der Seite der Arbeitnehmer, bei Kundenverhältnissen auf Seite des Kunden usw.

Herr Rost äußerte sich auch recht eindeutig zum aktuellem Konflikt Landesdatenschutzbeauftragter vs. FB. Da auch Vertreter der „datenschutzkrischen Spackeria“ anwesend waren, war die Diskussion naturgemäß recht polarisiert. Auch ich konnte zur Diskussion beitragen. Der Vortrag wurde per Livestream verbreitet und wohl auch aufgezeichnet und kann hier als Konserve rezipiert werden.

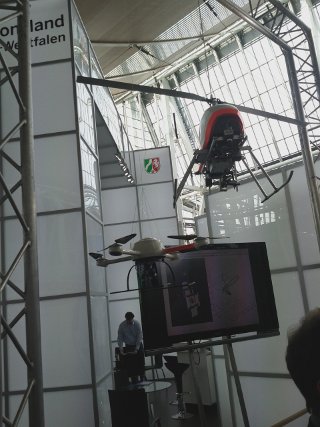

Halle 23 (als Ersatz für Halle 9) war für mich wie immer der interessanteste Bereich auf der CeBIT. Auch in diesem Jahr waren wieder einige Roboter und auch autonome Quadcopter zu sehen. Die Networked Embedded Systems Group der Universität Duisburg-Essen präsentierte auf dem Gemeinschaftsstand des Wissenschaftsministeriums des Landes Nordrhein Westfalen (auf dem ich 2007 und 2010 auch schon ausgestellt habe) einen Quadcopter.

Neben Quadkoptern dominierten in diesem Jahr humanoide Roboter wie der Nao, den es bei mehreren Universitäten zu sehen gab.

Ein weiterer Schwerpunkt lag bei HCI (Human–computer interaction) für Service Roboter. Hier wurden im Bereich Robotik technisch meist weniger aufwendige Lösungen gezeigt, die Mimik einfach mittels Computergrafik erzeuten und z.B. mit Hilfe eines Beamers einfach von Innen auf das „Gesicht“ des Roboters projezieren.

Ein mobiler Roboter, der mir auf Anhieb sehr bekannt vorkam war ein Exponat der Fraunhofer Gesellschaft. Die eingesetzte PowerBot-Plattform stammt auch von Mobilerobots wie der Pioneer 3AT Roboter des Lehrgebietes PRT, den ich ja auch schon auf der Cebit präsentiert habe. Interessant war hier die Sensorfusion mit einem Microsoft Kinect. Die Idee den 3D-Sensor Kinect für Robotik einzusetzen hatte ich sofort nach dem Erscheinen.

Der Fraunhofer-Mitarbeiter am Stand sagte mir, dass das Kinect von vielen Forschern nun dafür eingesetzt wird. Ein 3D-Sensor für 150 € schreit natürlich nach einer Anwendung in der Robotik. Am Fraunhofer Stand war in der Visualisierung der Sensordaten des Roboters eindeutig zu sehen, dass das Kinekt einem teuren Sick-Laserscanner hoch überlegen ist. Vielleicht liest ja einer meiner ehemaligen Robotik-Kollegen mit ![]()

Fraunhofer hatte mit der Mimikerkennung Shore ein weiteres Highlight auf der CeBit. Hier schließt sich auch wieder der Kreis zum Thema der CeBit 2012. Solche an sich sehr spannende Technologien (Mimik- und Gesichtserkennung) eingesetzt im Zusammenhang mit Quadkoptern und Drohnen in der Überwachung von Menschenmengen zeigen, dass wir in Zukunft wirklich „Vertrauen managen“ müssen um Freiheitsrechte wie Privatsphäre gegenüber einem Orwellschen Leben in Sicherheit zu verteidigen.

Dieses Mal wieder als Besucher: Die CeBIT 2011

Gutes und schlechtes

Nach dem Besucherandrang zu urteilen hat sich die CeBIT erholt, auch bedeutend mehr Anbieter sind vor Ort. Während letztes Jahr gefühlt 30 Prozent der Flächen leer standen, ist nun endlich wieder etwas zu sehen. Thematisch wurde dieses Jahr die Cloud durchs Dorf getrieben. Das Niveau im Webciety ist leider eher gesunken.

Was wirklich erschreckend ist, dass die angeblichen IT-ler brav das Registrierungsformular ausfüllen, samt Mailadressen und Position/Beruf/Firmengröße. Aus eigener Erfahrung als Aussteller weiß ich, dass die Messe AG die Ihr bekannten Mailadressen weitergibt, was dazu führt, dass der geneigte Aussteller in den Folgejahren mit Print- und Mail-Material von diversen Hotel/Messetechnikanbietern zugemüllt wird. Deshalb ist bei der Registrierung (wie überhaupt beim Umgang mit den eigenen Daten) Vorsicht angebracht.

Ein weiteres Ärgernis, der mobile Messeplan, neben dem iPhone nur für Android ab Version 2.2 (und buggy) verfügbar, also hat die Messe Dilettanten ans Werk gelassen die brav nur für die allerneueste API kompiliert haben. Ein Großteil der aktuellen Android Smartphones läuft noch unter 2.1 oder 1.6. Ich denke, es gibt keinen vernünftigen Grund, der bei so einer einfachen App eine Beschränkung auf 2.2 rechtfertigt. Die Bewertungen im Market sprechen Bände. Andere mobile Plattformen als iPhone und Android scheint die Messe AG nicht mehr zu kennen. Die mobile Webversion des Messeguides ist prinzipiell zu begrüßen, die heftige Verbreitung von Smartphones hat dazu geführt, dass ich erstmals Probleme hatte in das UMTS-Netz zu kommen, allerdings war ich im O2-Netz und nicht wie bisher in einem D1-Netz (natürlich Reseller ![]() ) unterwegs.

) unterwegs.

Jetzt aber mal zu den interessanten Dingen fernab der Cloud- und Socialmedia-Adepten die es zu sehen gab. Ich hatte die Gelegenheit auf dem Stand des Innovationsministeriums NRW alte Kollegen von der FernUni und auch Mitstreiter der Standorganisation zu treffen. Auch die Universität Duisburg-Essen ist an diesem Stand vertreten.

Android

Es gab allerhand Android-Tablets live und ‘touchy’ zu testen, meine Entscheidung bei einem Tablet nicht unterhalb eines ARM Cortex A8 Prozessors einzusteigen (Archos IT 7.0 mit Android 2.2, Multitouch, Flash, wenn man es denn möchte, und natürlich im Gegensatz zu den Apple-Produkten mit USB- und SD-Karten-Anschluss) hat sich wohl gelohnt. Das Pearl-Tablet sowie eine Menge anderer Noname-Androiden mit schwächeren Prozessoren ruckeln doch etwas vor sich hin. Pearl warb auch mit dem angeblich ersten 99 Euro Androiden, den es ja von Vodafone schon gibt. Spannender war dort (bis auf den gewohnt trashigen Auftritt) eine Android-2.2 basierte Settopbox/Mediacenter für 89 Euro mit zwei USB-Ports/LAN/WLAN optional/HDMI und SD-Card Anschlüssen. Durch HDMI DVI-D-Kompatibilität eigentlich auch als Thinclient für Webapplikationen verwendbar! Also fast schon “Green IT” (siehe unten) mit Android!

UPDATE: Teletarif war schneller und hatte das Teil auch schon gefunden ![]() .

.

So richtig klasse fand ich auch das 10-Zoll Android-2.2 (3.0 ab 4/2011) Tablet MID1015 von Coby.

3D-3D-3D

Autostereokopische Displays scheinen, wie schon in meiner Diss. seinerzeit 2005 prognostiziert (und sogar selbst geschrieben ![]() )nun endlich im Consumer-Markt anzukommen. Allerdings eignen sich diese Displays bisher nur größere (oder im Fall von Eyetracker basierten Systemen nur für definierte) Betrachtungsabstände. Trotzdem werden diese Displays zu mindestens in der Außenwerbung zukünftig häufiger zu sehen sein.

)nun endlich im Consumer-Markt anzukommen. Allerdings eignen sich diese Displays bisher nur größere (oder im Fall von Eyetracker basierten Systemen nur für definierte) Betrachtungsabstände. Trotzdem werden diese Displays zu mindestens in der Außenwerbung zukünftig häufiger zu sehen sein.

Eine weitere erfreuliche Entdeckung machte ich auf dem Stand von Zeiss: Ein OLED-basiertes Stereo-Vision Head Mounted Display mit der Bezeichnung Cinemizer OLED, welches wohl für ca. 300 Euro (also ein fünftel von dem was ich vor fast 10 Jahren für so ein Gerät für die Forschung ausgeben musste) auf den Markt kommen wird.

Forschung

Die Halle 9 ist immer spannend, nicht nur der Public Sector, der mich nun mit Entwicklungen wie z.B. dem elektronischen Personalausweis nun auch professionell für das Identitymanagement interessiert. Auch der Forschungsbereich, in diesem Jahr CeBIT-lab genannt, gibt immer etwas spannendes her. Neben dem Mobile Learning Projekt der FernUniversität in Hagen hat mich sofort der humanoide NAO Roboter der HTWK Leipzig fasziniert.

Open Source Parc

In der Halle2 im Open Source Parc habe ich spannende Vorträge zu Debian Squeeze (gibt es auch auf Radio Tux) und einen grandiosen Vortrag von Karsten Gerloff von der Free Software Foundation Europe gesehen. Die Essenz: „Think for yourself! Use technology. Don’t let it use you“. Endlich einmal jemand der Soziale Netze auch kritisch sieht. Zum Beispiel der über Facebook organisierte Widerstand gegen die Regimes in Nordafrika kann für die Teilnehmer gefährlich werden wenn ihre Identität nicht geschützt wird. Siehe dazu auch http://www.freedentity.org.

Auch die Cloud wurde von den Open Source Verfechtern aufs Korn genommen, a la Open Source hält was die Cloud verspricht. Konkret geht es um private Clouds die mit der deutschen Datenschutzgesetzgebung kompatibel sind.

Green IT

Zum Thema “green IT”, das ja auch einmal ein CeBIT-Buzzword war, habe ich eine empfehlenswerte Broschüre vom Umweltbundesamt gefunden. Dort werden Thesen vertreten die ich ähnlich auch einmal zum Besten gegeben habe: z.B. Mobiltelefone und Computer durch den Einsatz von Open Source Software länger nutzen. Der chinesische Anbieter nheolis zeigt mit der nheowind 3D eine kleine Windturbine mit 1,5 kW Leistung.

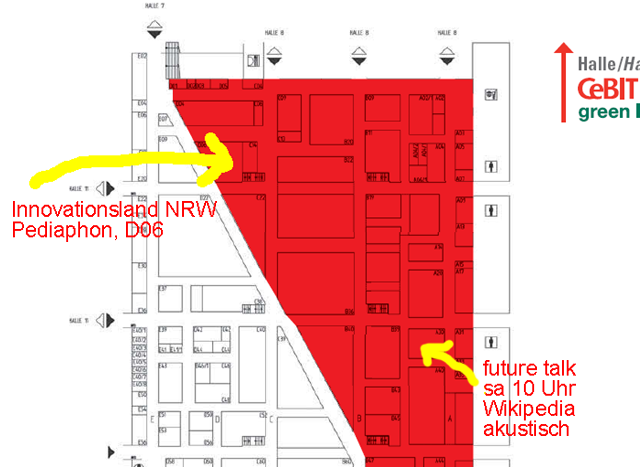

Das Pediaphon auf der CeBIT 2010 Hannover, 2.-6.3.2010, Halle 9 Stand D06

Ich stelle das Pediaphon mit einem neuen

Mobilinterface auf der CeBIT 2010 als beispielhafte Anwendung für mobile Learning (mLearning) aus. Auf dem CeBIT-Stand des ‘Innovationsland NRW’ (Hannover 2.-6.3.2010, Halle 9/Stand D06, Innovationsland NRW) zeige ich das Pediaphon, aufgrund von Terminengpässen mit aktuellen PRT-Projekten kann ich leider nur vom 4.-6.3. am Stand sein. Ich teile mir den Stand mit den Kollegen Maciej Kuszpa und Sandro Mengel vom Forschungsprojekt Mobile Learning an der FernUniversität in Hagen. Durch die Zusammenarbeit mit dem Lehrgebiet Bildungstheorie und Medienpädagogik ergeben sich spannende Synergien für mLearning an der FernUni.

Beim ‘future talk” Event in der Session zu ‘future learning’ werde ich am Samstag einen Vortrag zum Thema ‘Wikipedia akustisch – Mobile Learning mit dem Pediaphon’ beisteuern.

(Samstag, 6. März 2010, um 10.00 Uhr, (Halle 9, Stand A30)

Als Eyecatcher gibt es dieses Mal einen neuen Roboter zu sehen:

Pioneer Roboter im UMTS-Netz als Server, nun weltweit einsetzbar unabhängig von WLAN-Netzen

Die Fernbedienung des Pioneer 3 AT Mobilroboters über Mobiltelefone habe ich

bereits 2006 realisiert. Nun ist nicht nur das Telefon sondern auch der

Roboter über das UMTS-Netz direkt an das Internet angebunden. Damit der

Roboter als Server agieren kann, was im UMTS-Netz wegen privater IP-Adressen

eigentlich nicht möglich ist (wahrscheinlich als Sicherheitsfearture

gedacht), sind mehrere SSH-Tunnel zu einem öffentlich erreichbaren Rechner

aufgebaut worden, so dass Kommandos und Video-Stream an beliebige Clients

(auch in das UMTS-Netz) weitergeleitet werden können. Wenn die

UMTS-Netzversorgung nicht gegeben ist, findet ein Fallback zu GPRS statt

(grüne LED anstatt Blau für UMTS, siehe Bild). Angebunden ist der Pioneer

über ein Huawai E169 USB-UMTS .Modem (in USB-Stick Bauform auch unter dem

Namen Vodafone Mobile Connect Model K3520 HSDPA USB STICK ohne Simlock im

Handel erhältlich). Beide Geräte (der PDA und der Roboter) arbeiten zur Zeit

im D1-UMTS-Netz (MoobiAir), für das hier am Lehrgebiet zwei

Datenflat-Verträge verfügbar sind.

Für die Unterstützung des HUAWEI E169 musste der Linux-Kernel des Roboters

auf die Version 2.6.18 gebracht werden. Die Einwahl übernimmt hier wvdial

auf der Konsole, mit usbmodeswitch muss das Modem noch zur Zusammenarbeit

mit Linux überredet werden, da es sonst nur als ‘usb storage’ (was wohl als

Feature für die Erstinstallation der Windowstreiber gedacht war) erkannt

wird.

Girls Day 2009

Unsere Robosapien RS Media Roboter waren anlässlich des Girls Day 2009

wieder erfolgreich im Einsatz. Die Mädchen waren begeistert, offensichtlich

ist die Robotik ein ganz großes Thema sobald nur das Interesse geweckt

wird. Vielleicht waren einige zukünftige Ingenieurinnen und

Informatikerinnen in unserem Labor zu Besuch. Auf der Wiki-Seite zum Girls

Day 2009 am Lehrgebiet Prozesssteuerung und Regelungstechnik gibt es noch

mehr Informationen dazu. Auch unsere Pressestelle berichtet dazu.

Das von Schülerinnen beim Girls Day gedrehte Video dazu (betreut von einem

Team aus Pressestelle und Zentrum für Medien und IT):

Robosapien RS Media als Eyecatcher auf dem FernUni-Learntec Stand

Der schlaueste Roboter der Welt: Einen modifizierten Robosapien RS Media

Roboter habe auf der diesjährigen Learntec 2009 als Eyecatcher eingesetzt.

Dieser humanoide Roboter kann über ein von mir entwickeltes Webinterface fernbedient und dazu bewogen werden beliebige Artikel aus der Wikipedia mit den Pediaphon-Stimmen zu sprechen. Hier ein Screenshot des Webinterfaces mit Windows Mobile und eine weiterer mit Android (noch als Emulation):

Die Learntec bietet neben fachlichem Austausch auch immer wieder Gelegenheiten Mobile Learning Pioniere wie Maciej Kuszpa und Oliver Pincus zu treffen. Maciej Kuszpa hat mich auch fotografiert:

Foto: Maciej Kuszpa

Maciej Kuszpa, ich und Sandro Mengel (KSW)

Foto: Der Robosapien hat hier fotografiert!

Noch mehr Fotos (auch vom Roboter) gibt es auf den Seiten unserer Pressestelle und im

KSW-Medienblog. Manuela Feldkamp von der Pressestelle hat auch einen ‘Podcast’ erzeugt:

Und auf der Learntec Startseite ist wohl nun auch ein

kleines Video verfügbar

in dem ich auch kurz im Interview auftauche ![]()

Ein wenig Presseecho hat es auch gegeben:

http://www.welt.de/wams_print/article3166823/Technik-fuer-modernes-Lernen.html

http://www.managerseminare.de/Trainingaktuell/Archiv/News?urlID=174190