Akustikkoppler

bloggen mit 300 Baud – das Weblog von Andreas Bischoff

Kategorie: Allgemein

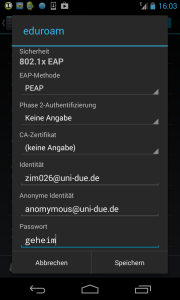

Warum Sicherheit leider immer kompliziert sein muss – ein separates, neues Passwort für eduroam an der Universität Duisburg-Essen nicht nur gegen die Android Enterprise WPA2-Lücke (WLAN Eduroam Sicherheitslücke Android)

Für technisch Interessierte hier die “ganze” Android-eduroam-Story.

Auch wenn die dem eduroam-Verbund zugrundeliegende Infrastruktur als sicher gelten kann, könnten doch unzureichend implementierte Radius-Klienten in Mobilgeräten die eigentlich sichere Umgebung untergraben. Bei drahtlosen WLAN-Netzen muss der Client immer überprüfen, ob er mit dem richtigen Accesspoint verbunden ist. Eine SSID (den Namen des WLAN-Netzes) kann jeder Angreifer sehr leicht kopieren. Deshalb sind offene WLANs auch immer gefährlich.

Ein Client kann niemals sicher sein, dass bei einer DNS-Anfrage wirklich die dazu passende IP-Adresse zurückgeliefert wird. Nur wer in offenen Netzen verschlüsselt per https kommuniziert und auch wirklich die in dieser Verbindung verwendeten Zertifikate überprüft, kann sicher sein mit dem richtigen Server verbunden zu sein. Wer im Web Zertifikatswarnungen ignoriert kann dort, wie auch im richtigen Leben, von Betrügern übers Ohr gehauen werden. Bei herkömmlicher WEP- (das Verfahren ist unsicher) oder WPA-Verschlüsselung ist durch das sowohl dem Klienten als auch dem Accesspoint bekannte Passwort sichergestellt mit dem „richtigen“ Accesspoint zu kommunizieren. In Firmen- oder Hochschulnetzen ist ein einfaches WPA-Passwort aber nicht praktikabel und so kommt das Radius-Protokoll ins Spiel. Ursprünglich für die Authentifikation in Modem-Einwahlnetzen konzipiert, kann Radius auch in WLAN-Netzen mit dem Standard 802.1X (ursprünglich vorgesehen für LANs) eingesetzt werden.

Um sicher mit einem Radius-Server zu kommunizieren, werden in 802.1X (Extensible Authentication Protocol) die Methoden TTLS (Tunneled TLS) und PEAP (Protected EAP) eingesetzt. In beiden Fällen handelt es sich prinzipiell um einen sicheren TLS-Tunnel wie er auch von https oder ähnlich bei SSH-Verbindungen genutzt wird. Wie bei diesen Verbindungen ist auch bei Enterprise WPA (802.1X EAP) das Zertifikat entscheidend.

Ohne Überprüfung des Zertifikats gibt es keine sichere Verbindung! Wer auf die Zertifikate im eduroam WLAN verzichtet, handelt grob fahrlässig!

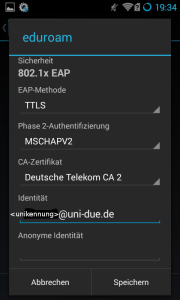

Abb. 1 So ist eduroam korrekt konfiguriert

Übrigens wird die Unikennung nur im Tunnel übertragen, d. h. wenn ein UDE-Nutzer z. B. an der TU-Dortmund unterwegs ist, sehen die Kollegen dort nur die äußere anonyme Identität, welche nach unserer Anleitung „anonymous@uni-due.de“ lauten soll. Der Suffix „uni-due.de“ ist wichtig, damit die Anfrage über die Radius-Server des DFN-Vereins an unsere Radius-Server weitergeleitet werden kann. Innerhalb des sicheren Tunnels kann die Authentifikation mit einem Klartextpasswort (PAP) oder viel sicherer mit MSCHAPv2 stattfinden. Bei MSCHAPv2 werden nur Hashes (challenge/response) ausgetauscht, das Klartext-Passwort wird niemals übertragen. Das auf dem veralteten DES-Verschlüsselungsverfahren beruhende MSCHAPv2 ist aber angreifbar. Klartextauthentifizierung mit PAP sollte aber in keinen Konfigurationsanleitungen mehr empfohlen werden!

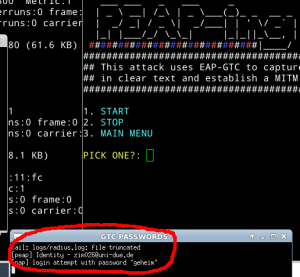

Neben der vom DFN-Verein beschriebenen Sicherheitslücke (1) im Android-Radius-Klienten bei der Konfiguration mehrerer Enterprise-WPA-WLAN-Profile, übrigens ein ungewöhnlicher Fall – nur wenige unserer Kunden haben daheim einen eigenen Radiusserver – gibt es weitere Sicherheitslücken, die sich bei unzureichend konfigurierten Klienten ausnutzen lassen. Ein Angriff auf einen unserer Kunden wurde im Mai 2014 mit dem Exploit „PEAP-ing TOM“ (3,4) durchgeführt. Durch diesen Exploit lassen sich nur Geräte angreifen, die unzureichend konfiguriert sind. Ein modifizierter Radius-Server bringt den Android-Klienten dazu sein Passwort per GTC (Generic Token Card, ein one-time Passwort) herauszugeben.

Um per PEAPing TOM angreifbar zu sein, reicht es aus in die Android-WLAN-Konfiguration kein Root-Zertifikat und keine Phase 2-Authentifizierungsmethode einzugeben (Siehe Abbildung 2).

Abb. 2: unten: So nicht! Ein angreifbares Android Profil – oben: das Angriffswerkzeug

Leider vertraut Android (in allen Versionen, erst Android 5 ist sicher) auch bei korrekt konfiguriertem eduroam-Zugang allen Zertifikaten unterhalb der Deutschen Telekom Root und nicht nur den Zertifikaten unserer Radius-Server. Daher würde der beschriebene Angriff auch funktionieren, wenn der Angreifer ein gültiges Zertifikat unterhalb der Telekom Root besitzt (2). Auch MSCHAPv2 im inneren Tunnel hilft nicht wirklich zuverlässig, da auch dieses angreifbar ist (5). Alle unsere eduroam-Konfigurationsanleitungen für Android sind seit dem Frühjahr 2014 auf dem aktuellen Stand. Wir können aber nicht sicherstellen, dass nicht noch Kunden mit falscher Konfiguration unterwegs sind. Aufgrund der Vielzahl der mobilen Klienten, deren Integrität nicht immer überprüft werden kann, erschien es uns sinnvoll ein separates WLAN-Passwort einzuführen. Dazu wurden sowohl die zentrale Benutzerverwaltung AUM als auch die Radius-Server angepasst.

Als Reaktion auf die Android-Sicherheitslücken planen alle UAR-Rechenzentren gemeinsam die Einführung eines optionalen separaten Passwortes für eduroam. Übergangsweise wird das bisherige zur Unikennung passende Passwort für eduroam weiterverwendet werden können. Wenn ein Kunde ein separates Passwort konfiguriert, wird ausschließlich dieses für die eduroam-Authentifikation verwendet werden. Mittelfristig wird von den UAR-Rechenzentren eine Authentifikation mit persönlichen Zertifikaten angestrebt.

(1) https://www.dfn-cert.de/aktuell/Google-Android-Eduroam-Zugangsdaten.html

(2) https://h4des.org/blog/index.php?/archives/341-eduroam-WiFi-security-audit-or-why-it-is-

broken-by-design.html

(3) https://www.youtube.com/watch?v=-uqTqJwTFyU

(4) https://www.leviathansecurity.com/blog/peap-at-def-con-21/

(5) https://www.heise.de/security/artikel/Der-Todesstoss-fuer-PPTP-1701365.html

Bericht vom 31C3 Chaos Communication Congress in Hamburg 2014 – „A new dawn“.

Man stelle sich so etwas einmal vor! 13000 Menschen aus aller Welt treffen sich auf einer Konferenz. Alles ist perfekt organisiert und sprüht trotzdem geradezu vor Kreativität. Es sind Flächen und Arbeitsplätze und Hackspaces für alle möglichen Hard- und Softwareprojekte vorhanden und man kann allen über die Schulter schauen, fragen und bekommt nette Antworten – überall steht Medienkunst herum! Über 1000 Menschen arbeiten als Freiwillige und niemals kommt Stress oder Frust auf, alle sind freundlich zueinander und helfen sich mit Strom- und Netzwerkkabeln aus. Es gibt ein eigenes GSM-, SIP- und DECT-Telefonnetz. Schon ohne die spannenden Themen der Vorträge auf der Konferenz lohnt der Besuch und hinterlässt einen nachhaltigen Eindruck.

Der Kongress fand im Hamburger Congress Center HCC statt. Als Maskottchen dient eine 5 m große Rakete.

Im Programm tummeln sich allerdings Berühmtheiten wie Richard Stallman (EMACS Autor und GNU-Aktivist, der Vater freier Software), Jacob Appelbaum und Laura Poitras höchstpersönlich, deren Film Citizenfour über die Snowden-Enthüllungen ebenfalls auf den 31C3 gezeigt wurde. Was Security-Themen angeht, ist das Niveau dort sehr hoch und es gibt viel zu lernen über Sicherheitslücken und Möglichkeiten sie zu beheben. Neben den technischen Vorträgen kommen auch gesellschaftliche, ethische und politische Aspekte der IT dort nicht zu kurz.

Alle Kongressvorträge können als Konserve abgerufen werden unter

http://media.ccc.de/browse/congress/2014/.

Einige interessante Vorträge möchte ich hier aber explizit empfehlen:

Iris-Detektion und Fingerabdruckscanner

Angriffe auf Iris-Detektion und Fingerabdruckscanner wurden in Starbugs sehr unterhaltsamen Vortrag „Ich sehe, also bin ich … Du – Gefahren von Kameras für (biometrische) Authentifizierungsverfahren“ vorgestellt. Unter Anderem wurde der Fingerabdruck von Ursula von der Leyen aus einem Foto extrahiert.

Scannergate

Was passieren kann, wenn die Digitalisierung dazu führt, dass (wie im modernen Dokumentenmanagement üblich) analoge Vorlagen gescannt und anschließend vernichtet werden, zeigt David Krisel in seinem unterhaltsamen Vortrag.

Freie Software

Richard Stallman hat in seinem sehr spannenden Vortrag den Unterschied zwischen freier Software und Open Source Software erläutert. Mit „frei“ ist hier nicht gratis sondern frei in Hinsicht auf Modifizierbarkeit und Weiterverwendbarkeit gemeint. Den Begriff „freie Software“ definiert Stallman als quelloffene Software die unter GPL-Lizenz die Weiterverwendung in Closed Source Software untersagt.

Proprietäre Closed Source Software hält Stallman generell für eine schädliche Entwicklung. Er sprach in diesem Zusammenhang von einer zwangsläufigen Entwicklung von propritärer Software hin zu Malware.

Stallman kritisierte insbesondere die i-Devices von Apple, welche die Nutzer in einem (bequemen) Gefängnis einsperren, aus dem erst ausgebrochen werden muss, damit das Gerät dem Nutzer und nicht dem Produzenten gehorcht. Er sprach von der „universal backdoor“ die Firmen wie Apple und Amazon in ihre Geräte einbauen, um die „Gewalt“ über diese Geräte ihren Nutzern vorzuenthalten. Diese universellen Hintertüren können die Hersteller jederzeit verwenden um die Nutzer Geheimdiensten wie der NSA oder dem GCHQ auszuliefern. Privatsphäre, die Möglichkeit vertraulich zu kommunizieren und den Schutz von Whistleblowern wie Snowden hält Stallman essentiell wichtig in einer freiheitlichen Gesellschaft. Er hält freie Software aus diesen Gründen für eine unverzichtbare Voraussetzung zum Erhalt von freiheitlichen Demokratien.

Microsoft / Apple

Warum Stallman sehr recht hat zeigen die beiden folgen Vorträge, die ich hier empfehlen möchte. Weshalb vor Windows 8 gewarnt werden muss erläutert Ruedi in seinem Vortrag zu Secure Boot. Aber die auch die Apple-Fraktion kann sich nicht in Sicherheit wiegen, wie der Vortrag von Trammel Hudson zum Thema „Thunderstrike: EFI bootkits for Apple MacBooks“ zeigt.

Netzpolitik

Zum Thema Microsofts Firmenpolitik in Sachen Cloud-Technologie versus europäisches Datenschutzrecht und die FISA-Court-Regelungen der amerikanischen Regierung sprach der Ex-Microsoft-Anwalt Caspar Bowden in seinem Vortrag „The Cloud Conspiracy 2008-2014“. Die Essenz ist: Kein Datenschutz für nicht Amerikaner in den USA!

Was sonst noch so alles aus den USA kommt, z.B. die mögliche Untergrabung unseres Datenschutzgrundrechte durch die derzeit im TTIP-Abkommen geheim (!) verhandelte “Schiedsgerichtsbarkeit”, wird im Vortrag von Katharina Nocun und Maritta Strasser klar.

Scada

Warum bei IT-Sicherheit der Fokus nur auf Banken, Webdiensten und Onlineshops liegt und warum Embedded Systems in großen Industrieanlagen vernachlässigt werden, treibt die Gruppe „Strangelove“ um, die sich mit Scada Sicherheitslücken beschäftigt.

Im Vortrag von Eireann Leverett „Switches got glitches“ zeigt der Autor wie er hartkodierte

Private Keys in Firmware Images findet. Er verwendet einfach grep (26:50)!

Netz

Für alle IT-Profis hochinteressant war der Vortrag zu der Infrastruktur auf dem 31C3-Kongressgelände. Dort stand insgesamt eine Bandbreite zur Verfügung die höher ist, als die einiger Staaten. Im letzten Jahr war die verfügbare Gesamtbandbreite auf dem Kongress sogar höher als die Bandbreite des Kontinents Afrika! Möglich wurde dies durch gesponserte Anbindung durch mehrere Internet-Provider. Auch die Hardware bestand aus großzügigen Leihgaben z.B. von Juniper. Das WLAN wurde mit Hardware des Herstellers Aruba betrieben, und war mittels aufgehängter Accesspoints in der Lage, vollbesetzte Veranstaltungsräume mit bis zu 3000 Sitzplätzen zu versorgen. Der Großteil der Besucher war mit PCs ausgestattet und im 5GHz mit 802.11a Band unterwegs (60 Prozent der dort verwendeten Endgeräte, im Konferenzwiki war vorsorglich darauf hingewiesen worden, nur solche Geräte mitzubringen). Die WLAN Netze im 2,4 GHz-Bereich waren dort konsequent mit dem Addendum „-legacy“ bezeichnet, um deutlich zu machen, dass diese Frequenzen nicht mehr verwendet werden sollen.

Der Vortrag ist hier zu finden (ab 8:10 zum Thema Wireless).

Raketen

Wer gerne einmal die Erde verlassen möchte (sicher alle Leser), oder wie ich schon immer mal eine Rakete bauen wollte, wird sich auch für die Technik dahinter interessieren. Warum Raketentechnik keine „Rocket Science“ sein muss, erklärt David Madlener in seinem lehrreichen Vortrag „Rocket science – how hard can it be?“. Auf seiner zweiten Folie taucht auch das Raketenmaskottchen des CCC wieder auf.

Bericht vom Mobile Learning Day (X)tended 2014 an der FernUniversität in Hagen

Wie immer großartig organisiert und trotz Bahnstreik sehr gut besucht war der Mobile Learning Day 2014 an der Fernuniversität in Hagen (Programm). Sehr spannend war das neue Konzept, welches neben Twitter (#MLDX14) nun auch auf einem eigenem Kanal interaktiv mit Padlet.com Rückmeldungen zu den Talks erlaubte Auch die Abstimmung zu kontroversen Themen im Plenum per Smartphone mit Pingo ist dort sehr gut angenommen worden. Die großartige Keynote von Prof. Manfred Mai ist aufgezeichnet worden und kann als Konserve hier online rezipiert werden. Es geht dort nicht nur um gute Lehre. Für mich der Kernsatz der Keynote:

“Entscheidend ist nicht was die Medien mit mir machen, sondern was ich mit den Medien mache.”

Diese Aussage erinnert mich an einen Satz, den ich einmal bezogen auf Technologie ähnlich aber in einem völlig anderem Kontext von Karsten Gerloff (Free Software Foundation Europe) gehört habe:

„Think for yourself! Use technology. Don’t let it use you“.

Auch die die spannende Präsentation von Prof. Bürgy zum Thema „Wearables“ war aus meiner Sicht einer der Highlights des Mobile Learning Day 2014. Vielleicht weil ich selber einen Xybernaut Wearable Computer (Bild) Zuhause habe, der auch auf Folie 29 rechts oben zu sehen ist.

Prof. Dr. Claudia de Witt (FernUni Hagen), Andreas Bischoff und Dr. Roman Götter (Fraunhofer Academy) (v.r.n.l.) – Foto: FernUni

Zu der Podiumsdiskussion mit dem Thema „Mobile Learning zwischen Realismus, Vision und Skepsis“durfte ich gemeinsam mit Frau Prof. de Witt (FernUniversität in Hagen, die Gastgeberin) und Dr. Roman Götter (Fraunhofer Academy) beitragen. Dort ging es um Personal Learning Environments auf mobilen Endgeräten, um die Hürden für die Durchsetzung mobiler Lernlösungen, um die mobile App des Jahres (mein Vorschlag war übrigens Google Cardboard) und um Prognosen zur Zukunft der mobilen Endgeräte. Es wurde kontrovers diskutiert, ob diese wirklich kleiner (Smartwatches) oder gar größer werden, wie derzeit zu beobachten ist (iPhone 6 plus, Phablets).

Eine Überblick zu der Veranstaltung gibt es im Best-Of Liveticker:

http://blog.fernuni-hagen.de/aktuelles/2014/11/06/live-ticker-mobile-learning-day-2014/

Die Folien der aller Vorträge sind auf http://mlearning.fernuni-hagen.de/mld14/ verfügbar.

Sprich Freund und tritt ein – Sprachausgabe für den Raspberry Pi mit eSpeak und SVOX-pico

Embedded Computer sind je nach Einsatzgebiet häufig nicht mit Bildschirmen oder Displays ausgestattet. Wenn sie aber in wechselnden Umgebungen mit oder ohne DHCP eingesetzt werden, ergibt sich häufig die Anforderung einmal schnell die bezogene oder eingestellte IP-Adresse herauszufinden. Natürlich lässt sich dieses Problem komfortabel mit DynDNS lösen, wenn der Rechner auch wirklich mit dem Internet verbunden ist. Ansonsten bleibt immer nur die Suche nach einem neuen Netzwerkgerät im Webinterface des Routers.

Diese Anforderung hatte ich selber ursprünglich für einen mobilen Roboter, der sich in wechselnden Umgebungen bzw. WLAN-Netzen bewegen konnte und per Webinterface bedient wurde. Um den Roboter initial zu finden, musste die IP-Adresse bekannt sein.

Aber auch für Zwecke der Heimautomatisierung eingesetzte Mini-Rechner müssen nicht immer mit Display betrieben werden. Für die Ausgabe seltener Störungen bietet sich das Audio-Interface, also die Soundkarte, als preiswerte und stromsparende Alternative an.

Mein mobiler Activemedia Pioneer 3AT Roboter mit Sprachausgabe 2006 FernUni in Hagen, damals realisiert mit MBROLA

Computergenerierte künstliche Sprachausgabe wird mit sogenannter Text-to-Speech-Software TTS realisiert. Diese Software setzt mit Hilfe von umfangreichen Aussprache-Lexika oder Heuristiken (Regeln) für die Zielsprache geschriebenen Text zunächst in eine Abfolge einzelner Laute (Phoneme) um. Die einzelnen Laute, bzw. deren Kombinationen werden entweder von einem Menschen bei der Erstellung der Software eingesprochen oder ebenfalls synthetisch (Signalsynthese oder Formantsynthese) erzeugt. Neuere Systeme basieren auf einem umfangreiche Wortschatz an von einem Menschen gesprochenen Worten, so das eine nahezu natürliche Sprache generiert werden kann. Selbst die Herausforderung eine natürliche Sprachmelodie (Prosodie) zu erzeugen, scheinen moderne kommerzielle Systeme zu meistern. Nun erfordert so eine hochqualitative Sprachdatenbank sehr viel Speicherplatz und ist aufwändig und teuer zu produzieren. Trotz allem gibt es im Open-Source-Bereich brauchbare und auch schlanke freie TTS-Programme. Eine sehr Ressourcen-sparende TTS-Software ist eSpeak. Diese Software wurde ursprünglich auf einem Acorn RISC_OS Computer, also auch auf einer ARM-Architektur, entwickelt und eignet sich durch Ihre Kompaktheit, Ausführungsgeschwindigkeit und geringen Speicherbedarf besonders für Embedded Systeme. Außerdem unterstützt espeak über 20 Sprachen. An die Aussprache muss man sich etwas gewöhnen, sie ist aber verständlich.

Die auf dem Raspberry-Pi verwendete Debian-Variante Rasbian unterstützt eSpeak out-of-the-box.

Mit

sudo apt-get install espeak

ist die Installation erledigt. Die Ausgabe testen kann man testen, nachdem man das Audiointerface auf den Klinkenstecker per Alsamixer umgestellt hat. Default ist beim Rasberry PI Audioausgabe über HDMI. In /etc/config.txt kann das aber auch fest eingestellt werden.

sudo amixer cset numid=3 1

espeak -vde “hallo welt hier spricht der räspberri pei”

Wenn keine Option -w angegeben wird, gelangt die Ausgabe direkt an das Audio-Device /dev/dsp .

Höhere Sprachqualität mit SVOX-Pico

Eine Alternative mit der derzeit besten Sprachqualität im Open-Source-Bereich stellt die SVOX-Pico-TTS-Engine dar. Vielleicht kommt dem einen oder anderen Nutzer die Stimme bekannt vor. SVOX-Pico ist die in den Android-Versionen 2.1-2.3 eingesetzte Default-Sprachausgabe. Die neue, ab der Version 4.0 von Google für Android eingesetzte TTS-Engine, basiert leider auf Closed-Source-Software. Die SVOX-Pico TTS-Engine ist übrigens auch die Default-Engine für meine Wikipedia-Sprachausgabe Pediaphon und unterstützt neben Englisch (UK und US), Deutsch, Französisch auch Italienisch und Spanisch in hoher Qualität.

SVOX-Pico liegt als Open-Source vor, ist auf diverse Linux-Varianten portiert worden und lässt sich z.B. unter Ubuntu einfach mit sudo apt-get install pico2wave installieren. Für Raspbian muss das Paket selber kompiliert werden. Alternativ können Sie mein Debian-Paket für Rasbian ARM einfach herunterladen (MD5-Hash: b530eb9ff97b9cf079f622efe46ce513) und mit den Kommandos

apt-get install libpopt-dev

sudo dpkg --install pico2wave.deb

auf dem Rasberry Pi installieren. Das libpopt-dev ist ebenfalls erforderlich.

Mit

sudo amixer cset numid=3 1

pico2wave --lang=de-DE --wave=/tmp/test.wav "hallo welt hier spricht der räspberri pei"; play /tmp/test.wav;rm /tmp/test.wav

können Sie die Sprachausgabe testen.

Mit

sudo apt-get remove pico2wave

kann man das Debian-Paket auch wieder sauber deinstallieren.

Wer selber kompilieren möchte, muss neben know how etwas Geduld mitbringen.

Um die Quellen zu kompilieren ist neben automake auch das libtool erforderlich:

git clone -b upstream+patches git://git.debian.org/collab-maint/svox.git svox-pico

apt-get install automake libtool libpopt-dev

automake

./autogen.sh

./configure

make all

make install

Alternativ kann man auch ein direkt ein Debian-Paket bauen, dass auch sauber wieder aus dem System entfernt werden kann.

Ich habe zusätzlich für mein Binary die GCC-Optionen

-mcpu=arm1176jzf-s -mfpu=vfp -mfloat-abi=hard

passend für den Raspberry Pi angepasst, damit auch die Hardware floation-point Unterstützung genutzt wird.

Um dann z.B. beim Bootvorgang automatisch die IP-Adresse des Pis zu sprechen, habe ich in der /etc/rc.local folgende Kommandos eingefügt:

/usr/bin/amixer cset numid=3 1

/usr/bin/espeak -vde "meine ei pie Adresse lautet $_IP"

Sicherlich lassen sich noch eine Menge anderer sinnvolle Anwendungen für eine Sprachausgabe auf dem PI finden. Mit seinen Sensoren kann der Pi auch als ein preiswertes Hilfsmittel für Blinde-Nutzer eingesetzt werden.

CeBIT 2014 Tipps – ein Merkelphone macht noch keinen Sommer – IT im Schatten der NSA-Affäre

Als Überzeugungstäter war ich auch im Jahr 2014 wieder auf der CeBIT, obwohl ich jedes Mal denke die Messe hat sich überholt. Man muss nicht wirklich dort gewesen sein. Aber die unaufgeregte fast provinzielle Atmosphäre dort gefällt mir wesentlich besser als die unglaublich hippe Dot-Com-Zeit im Hannover der Jahrtausendwende.

Obwohl Datenschutz auch auf den letzten beiden CeBIT-Messen ein Schwerpunktthema war, war ich doch gespannt, wie sich die NSA-Affäre auf die IP-Welt dort so auswirkt. Business as usual mit Daten weltweit verteilt in der Cloud, oder auch kritische Töne auf der IT-Messe? Die NSA-Affäre beginnt vielleicht nun einigen Anbietern wirklich Geld zu kosten und die Kunden sind für das Thema Datensicherheit sensibilisiert worden. Auf der CeBIT war dazu aber bis auf Lippenbekenntnissen recht wenig zu hören. Das Thema Cloud wurde weiter ge-hyped als ob nichts geschehen wäre. Allerdings gab es wieder viel Interesse an Live-Hacking-Events mit mobilen Endgeräten. Zumindest die Nutzer scheinen also sensibilisiert zu sein. Die Firma SecuSmart positioniert das Merkelphone nun auch für Firmen- und Privatanwender, aber das nützt nicht wirklich etwas, solange die Bundesregierung in der NSA-Affäre völlig untätig bleibt.

Ärgerlich war wieder einmal die CeBIT-App. Die Messe-AG greift in diesem Bereich immer wieder sicher ins Klo. Nicht nur das wirklich krude Bedienkonzept für eine App, die man ja nur kurz bei einem Messebesuch bedienen soll, sondern auch technische Dinge wie der Akku- und Datenverbrauch sind eine Katastrophe. Aussteller in der Suche zu finden ist Glückssache und ein Klick auf die Standnummer holt nicht etwa den Messeplan nach vorn, es passiert einfach gar nichts. Besonders glücklich ist der Messebesucher, wenn er für eine frisch installierte App sofort Datenupdates ziehen muss. Ich kann nur jedem Benutzer raten, sich einfach die PDF-Pläne herunterzuladen. Vielleicht kommt die Messe-AG ja einmal auf die Idee die Ausstellerdaten einfach als Datenbankexport öffentlich zu machen. Dann gibt es bestimmt sofort sehr viel bessere open source Lösungen.

Die CeBit App stürzt gerne mal ab und frisst Daten

Wirklich innovative Dinge bekommt man auf der CeBIT leider nur noch im Hochschulbereich zu sehen. Dort war das DFKI mit einem affenartigen Roboter zu sehen und hatte auch interaktives Fernsehen verknüpft mit semantic web im Gepäck. Eine schönen orangenen NAO habe ich mir direkt beim Hersteller Aldebaran angeschaut. Auch weiterhin werden NAOs leider nur an Hochschulen verkauft, Privatleute haben keine Chance. Der Preis liegt auch immer noch wie festgenagelt bei ca. 5000 €.

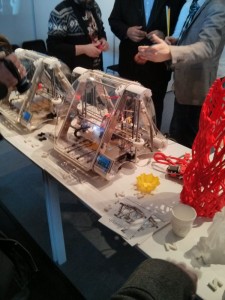

Absolute Publikumsmagneten waren 3D-Drucker von denen es eine ganze Batterie in unterschiedlichen Ausprägungen von unterschiedlichen Herstellern zu sehen gab (MakerBot Mini, Ultimaker, Airwoolf 3D, Zmorph). Pearl setzt dem Trend einmal mehr die Krone auf und bietet ein etwa Lötkolben-großes freihändiges Gerät für Leute mit absoluter Körperbeherrschung an. Eigentlich ist es aber nur eine bessere Heißklebepistole, die aber das gleiche Granulat wie in den 3D-Druckern als Druckmedium verwendet.

Auch Quadcopter-Drohnen scheinen nun im Endkundenmarkt angekommen zu sein. Die Firma DJI (www.dji.com) hatte von der relativ kompakten Phantom 2 Vision bis hin zu dem beeindruckenden, vielleicht sogar angsteinflößenden Modell mit der Bezeichnung „Spreading Wings S1000 Premium“, die eine ganze DSLR tragen kann, eine ganze Palette von Kameradrohnen im Programm. Nicht auszudenken wenn, wie bei Daniel Suarez im Roman kill decision jemand auf die Idee kommt die Nutzlast zu verändern.

Was mir auch noch außerordentlich gut gefallen hat sind die wirklich todschicken Rechner von “i am eco” (www.iameco.com), die eigentlich als nachhaltige Computer gedacht sind. Die edlen wohnzimmertauglichen Holzgehäuse sind aus nachhaltig in Europa hergestellten Hölzern gefertigt. Das wunderschöne D4R-Laptop (Notebook, auch die Bezeichnung scheint nachhaltig zu sein ![]() wird mit Abfallhölzern aus der Möbelproduktion aufgehübscht. Technisch verbinden die Rechner stromsparende, lüfterlose (das Standgerät mit Dual Core Prozessor und 7 Watt) Green-IT mit attraktiven Äußeren. Das „Laptop”-Notebook ist sogar auch mit aktuellem Core i7 Prozessor erhältlich.

wird mit Abfallhölzern aus der Möbelproduktion aufgehübscht. Technisch verbinden die Rechner stromsparende, lüfterlose (das Standgerät mit Dual Core Prozessor und 7 Watt) Green-IT mit attraktiven Äußeren. Das „Laptop”-Notebook ist sogar auch mit aktuellem Core i7 Prozessor erhältlich.

Diese Rechner sollen für 10 Jahre in Benutzung bleiben, was zunächst einmal recht ambitioniert klingt. Da sich ja auch in den letzten fünf Jahren die Taktfrequenzen nicht mehr wesentlich erhöht haben, kann das bei Verwendung geeigneter Betriebssysteme vielleicht sogar funktionieren. Auf jeden Fall sind die Geräte einfach schön und werden Ihren Markt sicher finden.

Stop watching us – Privatsphäre in Zeiten von PRISM

Welchen Diensten und Anbietern kann man heute noch trauen? Das fragen sich verunsicherte Nutzer von Datendiensten zurecht im Angesicht der immer neuen Enthüllungen in der NSA-Affäre bzw. im PRISM-Datenschutzskandal.

Wer schützt unsere Privatsphäre? Kann der Bürger der Bundesregierung in dieser Hinsicht noch vertrauen? Ist die Bundesrepublik Deutschland in dieser Hinsicht noch ein souveräner Staat? In der aktuellen Disskussion will keiner der Verantwortlichen in der Regierung etwas von den massiven Grundrechtsverletzungen gewußt haben. Offensichtlich ist auch das parlamentarische Kontrollgremium für die Kontrolle der Nachrichtendienste nicht informiert worden, so dass es keinerlei demokratische Legitimation für eine Zusammenarbeit deutscher Behörden mit dem PRISM-Programm der NSA gibt.

Ist die politische Führung unseres Landes ahnungslos gewesen, oder wird der massive Verstoß gegen Grundrechte billigend in Kauf genommen?

Da in beiden Fällen nicht darauf zu hoffen ist, dass der Staat den Bürgern bei der Wahrung ihrer Grundrechte auf Privatsphäre und informationeller Selbstbestimmung schützt, muss wohl der einzelne Nutzer selber für seine Privatsphäre sorgen.

Auf campact.de werden derzeit Unterschriften für die Gewährung von Asyl in Deutschland für Snowden gesammelt

Während Experten schon lange vermutet haben, dass Dinge, die technisch möglich sind, von Geheimdiensten auch getan werden (Echelon, mögliche Verbindungen von Facebook zu Geheimdiensten, the guardian 2008), sind viele begeisterte Nutzer von Web2.0-Diensten nun in Sorge um ihre Privatsphäre. Das Ausmaß des PRISM-Skandals ist erschreckend, da offensichtlich viele Anbieter von Diensten und Betriebssytemen betroffen sind. Die komplette Aufzeichnung jeglicher digitaler Kommunikation (auch aller Telefonate) hat Orwellsche Züge angenommen.

Es gibt aber für alle Dienste Alternativen. Etwas Informationsbeschaffung und ein wenig Verzicht auf Bequemlichkeit hilft die Privatsphäre zu stärken und den Datenschutz zu gewährleisten. Unter prism-break.org werden derzeit datenschutzkonforme Alternativen zu vielen Diensten gesammelt und vorgeschlagen.

Was kann ich für meine Privatsphäre im Netz tun?

- Benutzen Sie nicht mehr Google als Standardsuchmaschine.

Verwenden Sie einfach DuckDuckGo. Diese Maschine erlaubt eine anonyme Suche und legt kein Nutzerprofil an. Sie üben mit einer solchen Entscheidung Druck auf Google aus, mit den Daten der Nutzer datenschutzkonform umzugehen. Firmen wie Google leben von dem Vertrauen Ihrer Nutzer und werden durch die Abwanderung der Kunden gezwungen, sich dem PRISM-Programm entgegenzustellen. - Vorsicht bei Cloud-Diensten.

Wenn Sie überhaupt Cloud-Speicherdienste benutzen, verschlüsseln Sie Ihre Daten in einem Truecrypt-Container. Verwenden Sie Alternativen, wie z.B. OwnCloud. - Verschlüsseln Sie Ihre Daten.

- Nehmen Sie Einfluss!

Wenn Ihnen Ihre Privatsphäre wichtig ist, engagieren Sie sich und machen Sie Ihren Standpunkt bei Ihren Abgeordneten in den Parlamenten deutlich! Schützen Sie Edward Snowden indem Sie die Affäre weiter verfolgen. Bei campact.de werden derzeit Unterschriften für die Gewährung von Asyl in Deutschland für Snowden gesammelt. Auf https://optin.stopwatching.us können Sie einen offenen Brief an den US Congress unterschreiben. Die Plattform Avaaz sammelt ebenfalls Unterschriften für eine Petition an den US-Präsidenten Obama. - Verschlüsseln Sie Ihre Kommunikation.

Chat: Benutzen Sie nicht WhatsApp/Facebook Chat/Google Talk sondern Off-the-Record Messaging.

Mail: Signieren Sie Ihre Mail. Wenn erforderlich verschlüsseln Sie Ihre Mail mit PGP. - Vorsicht in sozialen Netzwerken.

Hinterlassen Sie dort keine Daten, die potentielle Arbeitgeber interessieren könnten. Alles war Sie beispielsweise bei Facebook hinterlassen, wird niemals wirklich gelöscht (auch Chat wird aufgezeichnet). - Meiden Sie Facebook.

Dieser Anbieter geht nicht datenschutzkonform mit Ihrer Privatsphäre um. Verwenden Sie diese Alternativen. Schreiben Sie in den sozialen Netzwerken nichts, was Sie nicht auch öffentlich sagen würden (siehe dazu auch diesen Artikel). - Verwenden Sie Open Source Betriebssysteme (Linux FreeBSD).

Quelloffene Software kann von Experten auf verborgene Hintertüren oder (viel häufiger) Programmierfehler hin untersucht werden. Bei kommerzieller Closed Source Software müssen Sie auf Gedeih und Verderb dem Anbieter vertrauen, dass Sicherheitslöcher wirklich geschlossen werden und dass keine Zugänge für Geheimdienste eingebaut sind.

Der Umstieg ist häufig viel einfacher als Sie denken. Wenn Sie Ihren Rechner überwiegend für Office-Anwendungen, E-Mail-Kommunikation und für das Web benutzen, müssen Sie sich nicht umgewöhnen. Wenn Sie mit kommerziell interessanten Daten arbeiten, sollten Sie sich fragen ob Sie Betriebssystemen von Microsoft oder Apple diese Daten noch anvertrauen können. - Geben Sie niemals Ihre Passwörter weiter!

Verwenden Sie niemals gleiche Passwörter für verschiedene Dienste. Lassen Sie niemals Dienste wie z.B. Linkedin (Facebook, Google … etc.) per E-Mail-Passwort-Login in Ihr E-Mail Konto schauen. Sie geben damit Ihren Account aus der Hand und geben die E-Mailadressen Ihrer Kontakte an den Anbieter weiter.

Einen Dienst, den wir alle benutzen und den es schon viel länger gibt als das Web, ist E-Mail. Auch bei Konfiguration von POP3 und SMTP über SSL bzw. TLS-Verschüsselung, kann nicht von einer sicheren Ende-zu-Ende-Verschlüsselung ausgegangen werden. Auf den Mailbox-Servern Ihres Providers sind ihre Mails immer unverschlüsselt gespeichert. In Deutschland ansässige Provider, wie GMX und Web.de, sind sicherlich viel vertrauenswürdiger, als beispielsweise Google Gmail. Das aktuell propagierte DE-Mail als verbindliche Kommunikation zwischen Ämtern und Bürgern realisiert aber keine sichere Ende-zu-Ende-Verschlüsselung, was Experten seit langer Zeit kritisieren.

Update: Und hier noch ein Link zu einem Video auf Youtube, dass die Problematik sehr schön erklärt. Danke an S. dafür ![]()

CeBIT 2013 – 3D-Drucker, Google Glasses Alternativen und BYOD

Obwohl es heutzutage viel einfacher ist sich im Web über innovative Technologien zu informieren und die CeBIT nicht wirklich immer schnell auf neue Trends reagiert, bin ich als Überzeugungstäter wieder dort gewesen.

Viele Aussteller weichen den Kugelschreiber- und Mauspad-Sammlern in den geschlossenen Planet Reseller Bereich aus. Tatsächlich war ich in diesem Jahr das erste Mal in diesem Bereich und war enttäuscht, dass es auch dort nur wenig wirklich interessante Dinge zu sehen gab. Scheinbar geht es bei diesem Bereich wohl nur darum Sex sells Geschmacklosigkeiten der Austeller vor dem Massenpublikum zu verbergen. Auf der nächsten CeBIT werde ich mir diesen Bereich wohl schenken. Pearl präsentierte aber nur dort einen interessanten Fensterputz-Roboter. Service-Robotik ist also massentauglich geworden.

Auch der Bereich Webcity nimmt an Relevanz leider stark ab. Mit Themen wie Social Marketing hat sich der Bereich nun sehr weit von dem ursprünglich innovativen Web 2.0 oder gar netzpolitischen Themen weit entfernt.

Sogar der Hochschulbereich hat mich dieses Jahr bis auf wenige Ausnahmen gelangweilt. Interessant fand ich aber das Echtzeit Facetracking dieses Mal eingesetzt für Videokonferenzen der RWTH-Aachen. Für Robotik-Interessierte gab es auch einen Unterseeroboter zu sehen. Anscheinend gibt es das Gerät nicht nur für zivile Zwecke (SeaOtter_civil.PDF) .

Trotzdem lässt sich die Messe AG auch neue Konzepte einfallen. Hervorzuheben bei den interessanten Neuerungen sind die Developer Area und der kleine Coworking Place in Halle 17. Sehr spannend fand ich den offenen Workshop zu 3D-Druckern. Allerdings vertraut die Messe AG anscheinend dem externen Anbieter Amiando mehr als ihrem eigenem Registrierungssystem ![]() .

.

Niels Hitze von 3ddinge.de stellte in der Developer Area Hard- und Software zum 3D-Drucken aber auch die Maker und Fabber-Bewegung vor. Trotz Probleme mit dem WLAN (kein Wunder auf der CeBIT) gab es die Möglichkeit einem Makerbot (dem Replicator 2) bei der Arbeit über die Schulter zu schauen. Neben Grundlagen zu Hard- und Software und Datenformaten gab es auch Erfahrungen in der Konstruktion von Abstützungen und Tipps zu Materialien, Materialeigenschaften und Finish aus erster Hand. Auch auf aktuelle ethische und politische Problemstellungen, wie beispielsweise die Produktion von Waffen mit 3D-Druckern und der aktuellen Diskussion zu Auswirkungen auf das Urheberrecht und geistiges Eigentum, die eine Welt von Fabbern aufwirft, wurde eingegangen. Auch vielleicht etwas SciFi-mäßig angehauchte Ideen der ESA Mondstaub als Medium für 3D-Drucker zu verwenden wurden erwähnt. Eine Thematik die für mich ganz neu war ist der Einsatz von 3D-Drucken die aus Eiweißen und Proteinen synthetische Lebensmittel oder sogar Fleisch “drucken”. Lecker, da bleiben die Pferde aus der Lasagne draußen.

Neben autostereoskopischen Displays ist auch Augmented Reality für Head Mounted Displays durch den Hype um die Google Glasses wieder ein Thema. Zeiss stellte eine Brille vor die ich vor zwei Jahren schon auf der CeBIT gesehen habe und die schon damals angeblich in einem halben Jahr serienreif sein sollte. Noch spannender war ein Kickstarter Projekt namens GlassUp, dass aber noch keine live Daten darstellen konnte.

Ein interessantes Thema auf der CeBIT war auch “Bring your own device (BYOD)”. Sehr viel Spaß hatte ich bei der Podiumsdiskussion am Donnerstag zu BYOD in Halle 6, Stand C04. Dort ging es im Rahmen des “Mobile Business Solutions Forum” um “BYOD – Fluch oder Segen für die Unternehmens-IT?“. Dort fand ich einige meiner eigenen Ansichten zum Thema BYOD bestätigt. Offensichtlich bin ich, sowohl mit meinen Sicherheitsbedenken, als auch mit der Ansicht, BYOD ist für die Nutzer großartig und faszinierend, nicht alleine.

The rebirth of the cool – mit webGL kehrt Virtual Reality endlich zurück ins Web

Ende des letzten Jahrtausends wurde die Virtual Reality Modeling Language als ein Austauschformat für 3D-Geometrien standardisiert (VRML97). Interessant wurde es aber erst als VRML im Web eingesetzt wurde.

Zunächst waren leistungsfähige und teure 3D-Grafik-Workstations von Silicon Graphics (SGI) nötig um 3D in Echtzeit auf einem Desktop darzustellen. Aber Ende der neunziger Jahre standen die ersten Grafikkarten mit OpenGL Beschleunigung auch für handelsübliche PCs zu Verfügung und so begann das goldenen Zeitalter der Virtuellen Realität im Netz. Um VRML im Browser darzustellen war ein Browser PlugIn erforderlich, das die Darstellung der 3D-Welten übernahm. Richtig spannend wurde VRML durch das sogenannte External Authoring Interface ( EAI), welches Java-Applets ermöglichte die 3D-Welten zu beeinflussen also zu programmieren. Zur Erinnerung: Damals waren Java Virtual Machines in den Browsern integriert (Netscape4, IE4).

Da nun die Nutzer der Browser schon damals wenig Lust (und wenig know how) hatten Webbrowser-PlugIns zu installieren, setze ich zu dieser Zeit viel Hoffnung in den Netscape Navigator 4.06 der mit einem VRML-PlugIn (CosmoPlayer) ausgeliefert wurde. Leider beendete der von Microsoft initiierte Browser-Krieg einerseits die Integration von Java in den Browser, andererseits gab Netscape auf und stellte den Quellcode des Navigator unter Open Source. Damit war das EAI verschwunden und es gab keine standardisierten Möglichkeiten mehr im Browser VRML Welten mit externen Schnittstellen zu programmieren. Selbst webbasierte Multiuser Virtual Reality Umgebungen wie VNET und Deepmatix funktionierten nicht mehr. Das viel spätere netzbasierte Second Life lief niemals im Browser und staubte den Hype ab.

Mit WebGL und dem API x3dom sind nun wieder standardisierte (X3D, der Nachfolgestandard zu VRML97) programmierbare (diesmal Javascript) 3D-Modelle im Browser möglich. Und das Ganze funktioniert sogar ohne PlugIn in aktuellen Browsern. Der IE von Microsoft bildet wieder einmal die unrühmliche Ausnahme. Leider hält sich dieser Konzern an keinerlei Standards. Aber x3dom verwendet für nicht unterstützte Browser ein Flash swf als Renderer für X3D, allerdings werden nicht alle folgende Beispiele im IE richtig dargestellt.

Ich erwecke hier den Puma-Robotersimulator wieder zum Leben, den ich im Jahre 2000 für das RichODL-Projekt an der FernUni in Hagen realisiert habe. Mit jquery wird hier das X3D DOM manipuliert um die Roboterachsen zu bewegen:

Ein mehr immersives Beispiel ist das PRT-Roboterlabor, welches ich 2001 in VRML modelliert habe:

Und die „Galerie oben“ der FernUni, die seinerzeit (2002) mit diesen Avataren bevölkert war:

In meiner Diss. habe ich mich im Jahre 2005 ausführlich mit diesen Techniken beschäftigt.

„The rebirth of the cool“ ist der Titel einer Acid-Jazz Compilation aus den Neunzigern.

#fail! Kein QR-Code für die U-TOPIA im Dortmunder U!

Nanu, da gibt es tatsächlich im Jahre 2012 immer noch Leute die die Funktion von QR-Codes nicht verstanden haben. Das ist besonders peinlich, wenn wie im Falle des U-TOPIA-Festivals für Musik, Kunst und Technologie im Dortmunder U, womöglich Medienkompetenz assoziiert wird. Da hat wohl ein naiver Designer den an sich funktionierenden Art-QR-Code invertiert, weil der Code so besser in die Gestaltung des Flyers passt. Nun gibt es einige wenige QR-Code-Scan-Apps die auch invertierte QR-Codes verarbeiten, aber das Gros der Programme kann damit nichts anfangen. Mit einer online Bildbearbeitung konnte ich den Code unterwegs schnell invertieren und auslesen, aber wie viele Leute machen so etwas?

So nicht! Das können nur sehr wenige QR-Code-Reader lesen. Und kein Hinweis auf den Inhalt!

Ganz besonders schlau sind dann auch noch selbsternannte „Viral-Marketing-Experten“, die einen Flyer wie den abgebildeten kreieren, auf dem kein weiterer erläuternder Text (oder gar die kodierte URL als Text für Leute, die womöglich kein Smartphone mit Kamera besitzen) enthalten ist. Damit ist der Flyer das Papier nicht mehr wert auf dem er gedruckt wurde.

Ein solcher QR-Code allein kann übrigens je nach Inhalt sehr wohl für den Nutzer auch gefährlich sein und sehr unangenehme Dinge mit dem Telefon anstellen. Beispielsweise können durch USSD-Codes (auch GSM-Codes genannt) mehrfach falsche SIM-Codes eingegeben werden und die SIM so gesperrt werden (siehe Heise). Wenn dann wenigstens ein Autor/Herausgeber auf dem Flyer angegeben ist, kann man den Verursacher zur Rechenschaft ziehen.

Also immer schön vorsichtig mit anonymen QR-Codes umgehen!

Auch auf dem überall in der Stadt geklebten Plakat für die U-TOPIA sind die invertierten Codes vorhanden. Hatte keiner der Entscheider die Medienkompetenz den hippen QR-Code einmal mit verschiedenen Readern/Plattformen auszuprobieren? Ein Trauerspiel! Das Dortmunder U sorgt ja momentan permanent für Schlagzeilen.

Auch auf auf dem Plakat leistet sich das U den Fehler, direkt neben dem Schriftzug “digitale Künste” ![]()

Übrigens hielt ich 2006 solche Codes, bzw. deren Vorläufer die DataMatrix-Codes, auch für neu und habe damals einen Online-Generator dafür ins Netz gestellt. Den im Artikel für Symbian und Windows Mobile (ja, auch damals gab es schon Smartphones ;-) ) empfohlenen QR-Code-Reader des Pioneer auf dem Gebiet mobiler QR-Codes Quickmark benutze ich heute in der Android-Variante.

Richtig neu war das Thema im Jahre 2000, erfunden würden solche Codes schon im Jahr 1994! Spannend und praktikabel wurden solche Codes mit der Verfügbarkeit preiswerter CCD-Kameras. Eine USB-Kamera ist seit einigen Jahren viel preiswerter als ein konventioneller Barcode-Reader.

Auf allen Plattformen funktionierende und professionell gestaltete Art-QR-Codes gibt es beispielsweise hier ![]() .

.

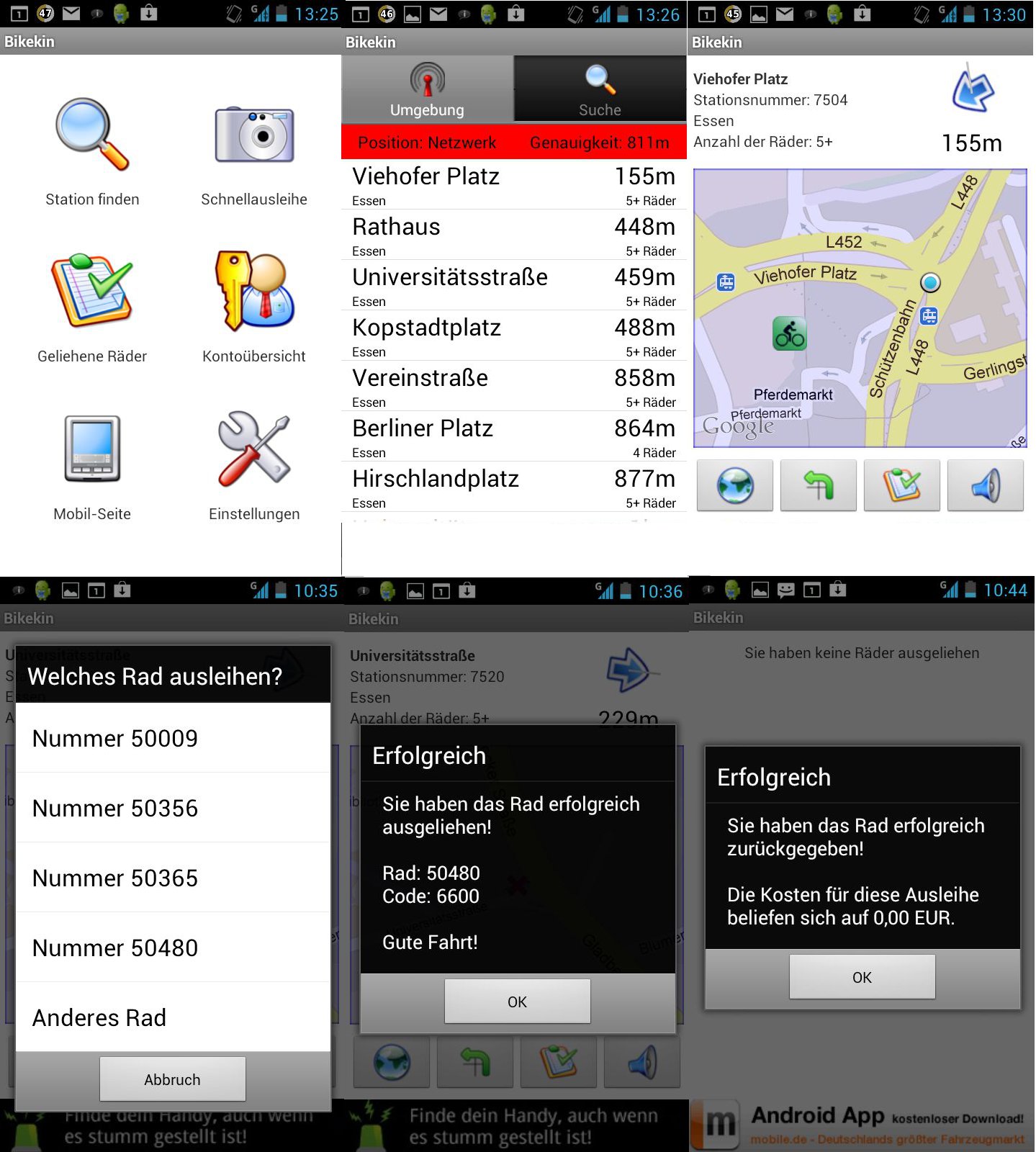

Dienstfahrt einmal anders – unterwegs am Campus mit Fahrrad und App!

Nicht nur die beiden Campi der Universität Duisburg-Essen sind etwas weiter voneinander entfernt, auch an den Standorten verfügt die Universität über verteilte Einrichtungen. Wenn häufig verschiedene entfernte Gebäude der Hochschule besucht werden müssen, bietet sich neben öffentlichen Verkehrsmitteln auch das Fahrrad als ökologisches und nachhaltiges Verkehrsmittel an. Wer mit dem Auto oder per ÖPNV anreist, hat aber meist kein Fahrrad zur Hand. Ein Dienstfahrrad wäre für diesen Einsatzbereich perfekt. An der Hochschule gibt es neben der Initiative „FAHR RAD UDE!“ auch weitere Initiativen zur Nachhaltigkeit . Die FAHR RAD UDE! verbreitet übrigens Neuigkeiten für Fahrradnutzer in einem eigenen Newsletter. Aber es gibt jetzt ja an vielen Standorten im Ruhrgebiet das „metropolradruhr“. Auch an beiden Campi und in der Nähe anderer Standorte sind neuerdings metropolradruhr Leihräder vorhanden.

Duisburg Uni-Nord Lotharstraße: Stationsnummer: 7421, Uni Lotharstraße / Walramsweg: Stationsnummer: 7422

Essen Universität: Stationsnummer: 7561, Universitätsstraße: Stationsnummer: 7520, Viehofer Platz: Stationsnummer: 7504

Weniger bekannt ist vielleicht, dass Inhaber eines VRR-Tickets (Ticket1000, Ticket2000, Firmenticket) täglich eine halbe Stunde kostenlos eines der Räder benutzen können. In Essen gibt es derzeit eine Sonderaktion „Stadtradeln in Essen“ (bis zum 22. September 2012 bis zu 24h kostenlos radeln, Gutscheincode 937937 im Kundenkonto eingeben). Ein besonderer Vorteil für das Szenario Dienstfahrt ist die Möglichkeit ein Fahrrad an einer anderen Station wieder abzugeben.

Die Nutzung nach Anmeldung bei www.metropolradruhr.de erfolgt bequem per Mobiltelefon. Als Bezahlverfahren sind Kreditkartenzahlung oder Bankeinzug vorgesehen. Die Zahlung per Kreditkarte kann bei diesem Anbieter allerdings nicht wirklich empfohlen werden, da im Zuge der Anmeldung eine Art Online-Konto bei einem Zahlungsdienstleister mit Namen Worldpay eingerichtet wird. Alternativ ist auch eine Anmeldung an VRR-Kundenzentren und Tourist Informationen möglich. Bei der Anmeldung sollte eine Mobilfunknummer oder eine E-Mailadresse angegeben werden (leider ist beides optional), da sonst eine sinnvolle Nutzung nicht möglich ist.

Ausgeliehen wird ein Rad einfach per Anruf, in einem einfachen Sprachmenü wird die Radnummer eingegeben und die Nummer des Zahlenschlosses wird angesagt. Zur Sicherheit wird der Schlosscode auch noch per SMS übermittelt.

Die Rückgabe erfolgt dann auch einfach per Anruf an der Zielradstation. Tatsächlich fahren Mitarbeiter des Anbieters umher, warten die Fahrräder und sorgen dafür, dass der Schlosscode regelmäßig geändert wird.

Besonders spannend wird die Nutzung der Leihräder aber erst für die Nutzer moderner Smartphones. Vom Betreiber Nextbike bereitgestellte Apps für Android und iPhone, bzw. eine für Andoid empfehlenswerte App eines Fremdanbieters (bikekin) ermöglichen eine sehr komfortable Ausleihe über das mobile Internet. Die Suche nach der nächstgelegenen Station mit aktueller Fahrradbelegung ist ebenso integriert wie neuerdings die komfortable Schnellausleihe per QR-Code.

Auch die Rückgabe erfolgt über das Internet, so dass keine Kosten für ein Telefonat anfallen. Interessanterweise arbeitet Metropolradruhr, bzw. die sich dahinter verbergende Firma Nextbike deutschlandweit, so dass in vielen Städten problemlos Fahrräder ausgeliehen werden können (selbst ausprobiert in Nürnberg und Berlin).

Im Ruhrgebiet wird derzeit das Angebot stark ausgebaut. Neuerdings sind auch alle Stationen mit einem eTicket-RFID-Reader ausgestattet, so dass dort mit dem Ticket direkt ausgeliehen und zurückgegeben werden kann. Auch eine Anmeldung ist dort nun möglich. Die Radstationen verfügen dazu über ein Mobilfunkdatenmodem und werden per Solarzellen mit Strom versorgt.

Wer bei der Dienstfahrt ins Schwitzen gerät, dem stehen als Angebot des Hochschulsports Dusch- und Umkleidemöglichkeiten für Radfahrer an beiden Campi zur Verfügung!